BLOGS

Quinta-feira,

25/2/2016

Blog de Claudio Spiguel

Claudio Spiguel

|

|

|

|

| |

Entrevista Anti-Crise

Julio,

Como eu temia, as perguntas que você elaborou para a entrevista são dirigidas a quem está atravessando a "crise" no Brasil, e portanto, como eu não resido no Brasil atualmente, fica um pouco difícil responder com o sentido almejado. No entanto, como eu acho que a "crise" Brasileira não é coisa recente ou de curto prazo (o buraco é mais embaixo...), vou tentar responder tentando fazer aflorar esse foco, e talvez assim uma contribuição minha para o "grupo anti-crise" possa fazer sentido. Dependendo do resultado, fica a seu critério como editor publicar ou não. Vamos lá:

Nota Posterior:Você pediu que publicássemos as entrevistas em nosso blog...

Entrevista AntiCrise: Claudio Spiguel

1. Conte um pouco de você e da sua atividade.

Tenho 67 anos, e estou aposentado há 13 anos. Sou Engenheiro pela Escola Politécnica da USP (como o Editor Júlio, só que um pouquinho mais velho... :-), e sou Doutor em Ciência de Computação pela Universidade de Michigan, nos EUA. Fiz minha vida e carreira profissional nos EUA, e me aposentei como Vice Presidente Corporativo e CIO (Chief Information Officer) da firma farmacêutica Astrazeneca, Inc. e como Professor Titular de Gerência Estratégica de Informação na Escola de Economia e Administração de Empresas da Universidade de Delaware. Hoje em dia minhas atividades se enquadram praticamente todas dentro do voluntarismo, por exemplo como Rotariano que sou há 11 anos, empregando minha experiência em Gerência de Projetos para assessorar iniciativas de aplicação de recursos pela Fundação Rotária Internacional em projetos que visam melhorar as condições de vida em comunidades em alto risco social ao redor do mundo. Participo também da Diretoria de tres entidades de ensino e administração sem fins lucrativos, e sou mentor no colegial local de alunos especiais no tema de como ter sucesso em uma carreira profissional. Mas considero minha atividade principal participar com minha esposa por 44 anos, Cristina, do crescimento dos nossos OITO netos, seis dos quais residem na mesma cidade que nós, Gainesville, na Florida, EUA.

2. Como a "crise" afetou você nos últimos tempos?

Antes de responder esta, é preciso definir a "crise". A crise no Brasil é crônica, desde que eu me entendo por gente. A atual administração apenas fez por exacerbar e oficializar o mar de lama que sempre correu por baixo do verniz. Essa crise crônica se nutre, na minha opinião, através de três maldições principais: a) Um total descaso e consequente pífio investimento em educação e conhecimento, que resulta em uma falta de educação generalisada em uma grande porcentagem da população; b) Um total desrespeito ao mérito e ética de trabalho. Sucesso no Brasil não é determinado por experiência e realizações, mas sim por em quantas cabeças se pisa na subida. Competência no Brasil não dá frutos... competência no Brasil incomoda; c) Um deboche completo às Leis do País, acoplado a um sistema de (in)justiça corrupto e risível. As consequências mais óbvias disso são a impunidade, e o famoso "jeitinho" Brasileiro... estas, na minha opinião, são as perdições do Brasil.

Assim definida a "crise", nem é preciso dizer como ela afetou, e ainda afeta, não só a mim, mas a todos os Brasileiros.

3. Como você está reagindo à crise? (Quais medidas adotou para se defender dela?)

Eu simplesmente saí do Brasil... na verdade saí do Brasil três vezes... a primeira, esperançoso e de certa maneira ingênuo, para estudar e aprimorar e aprofundar meu conhecimento; a segunda, decepcionado, mas sabendo que existem sociedades que funcionam a despeito dos problemas humanos que a pressionam; a terceira, há apenas alguns anos, cansado de tentar ajudar e com as mãos sangrentas de dar murro em ponta de faca, e saudoso da proximidade com filhos e netos. Não me orgulho de ter saído do Brasil, mas o trem da oportunidade passa na estação apenas algumas vezes na vida... se a gente não pula nele, ele passa e não volta. A vida é o que se faz dela...

4. Conhece outras pessoas na mesma situação? (Se sim, como elas estão fazendo para atravessar o momento?)

Muitas... todos os Brasileiros com quem interajo no exterior manifestam-se como se estivessem fugindo de situações impossíveis. E, sem exceção, pelo menos os que eu conheço são pessoas de bem, que querem estudar e trabalhar seriamente, progredir, e sentem que não há condições de fazê-lo no Brasil. Isso causa um problema sério de evasão de cérebros capazes, e uma espiral descendente que imortaliza a crise crônica descrita em 2. acima.

5. Você conhece alguém que - apesar da crise - está conseguindo se desenvolver de alguma forma? (Se sim, o que essa pessoa está fazendo de diferente?)

Sim... todos que eu mencionei em 4. acima, e uns poucos amigos no Brasil que dispõe de uma situação financeira que permite que eles "naveguem" acima das vicissitudes e dos altos e baixos do caos econômico que se instalou por conta da incompetência corrupta da liderança atual. Quanto ao "o que fazem diferente", acho que isso se resume a obedecer uma ética de trabalho decente e honesta.

6. Quais são as grandes "lições" desta crise, até agora, para você?

A maior lição da crise atual, no meu entender, é a corroboração de que com coisa séria não se brinca. Coisa séria, assim, como eleger um Presidente da República. Eu me lembro que um dos slogans usados pela liderança atual era "A Esperança Venceu o Medo"... Eu nunca entendi como pode haver Esperança em eleger incompetência para cargo de tamanha responsabilidade. E no caso do Brasil, ainda por cima uma incompetência corrupta e mal-intencionada. E quanto ao Medo, eu também nunca entendi... Medo... de que? Ficam aí as perguntas...

7. Acha que a crise, do jeito que está, vai longe (ainda)?

Infelizmente sim... pois como defini acima, a crise é crônica. Mas toda a corrente é tão forte quanto o seu elo mais fraco, e no caso do Brasil, o único elo que pode ser quebrado é através de investimento sólido na educação da população em geral. Medidas nesse sentido são cronometradas em gerações, portanto levam um longo tempo... a ver...

8. Como acha que o Digestivo pode ajudar você nesta travessia?

O Digestivo me ajuda muito como um canal de comunicação com e informação sobre o Brasil. Sou um dos blogueiros, e, portanto, o Digestivo também funciona como uma válvula de escape para mim direcionada ao Brasil. Continuar a ler e escrever em Português me ajuda a manter viva a língua mãe, e ensinar meus netos a serem bilíngues desde a tenra idade, o que no mundo de hoje é uma característica importante.

9. Se pudesse pedir alguma ajuda aos Leitores do Digestivo - para deslanchar seus projetos -, o que você pediria?

Gostaria de pedir que continuassem lendo meus posts. Publiquei durante o ano passado uma série de 13 artigos no blog contando uma História da Tecnologia da Informação, vista através das lentes da minha carreira profissional. Recebi muitos comentários elogiosos, e foi motivador... quem já leu, comente mais... quem não leu, leia e comente... é disso que vive um escritor amador. Este ano pretendo escrever sobre outros assuntos também... leiam e comentem... será um prazer interagir com TODOS os leitores!

10. Quais são seus links, seus contatos? Enfim, onde os Leitores podem encontrar e contatar você?

Além de através do Digestivo, eu posso ser contatado no seguinte e-mail:

[email protected]

Obrigado ao Digestivo Cultural na pessoa de seu Editor Chefe, Júlio Daio Borges, pela oportunidade de expor meus pensamentos através desta entrevista.

[Comente este Post]

Postado por Claudio Spiguel

25/2/2016 às 22h06

|

| |

Uma História da Tecnologia da Informação- Parte 13

Alô, caros leitores e leitoras... demorei mais do que pretendia para publicar este Epílogo, pois andei ocupado sendo Vovô pela OITAVA vez. Bem-vinda, LÍVIA PALKO SPIGUEL, minha terceira neta, nascida em 02 de Novembro p.p. Mas, voltando à vaca fria, esta Parte 13 é o Epílogo da Série: UMA HISTÓRIA DA TECNOLOGIA DA INFORMAÇÃO, que eu venho publicando neste meu blog. Lembro aos leitores e leitoras que não leram Partes 1 - 12, que vocês podem acessá-las "clicando" no Mais Claudio Spiguel aí embaixo no rodapé do texto.

Parece que não será muito fácil abandonar o tema tecnológico, principalmente porque boas perguntas continuam chegando dos leitores a respeito. Nas semanas desde a publicação da Parte 12, um leitor fez o seguinte comentário sôbre a série acima mencionada: "Você só fala das coisas boas da tecnologia da computação; seus exemplos são todos pioneiros, progressistas, como se só coisas assim existissem. Mas e as coisas ruins? E esses VÍRUS que quando entram no meu computador fazem da minha vida um inferno? Tudo na sua série parece ter um objetivo nobre; qual o objetivo dos vírus? AFINAL, PARA QUE SERVEM OS VÍRUS...?"

É possível que o leitor que fez esse comentário não se dê conta da profundidade da questão que êle levantou, motivado muito provàvelmente apenas pelo "inferno de vida" quando seu computador está "infectado". Na verdade, existe uma boa razão para esses programas indesejáveis a que o leitor está se referindo serem chamados de vírus, e essa razão é a similaridade deles aos vírus biológicos que causam consequências indesejáveis (infecções viróticas) em organismos vivos, como nós, outros animais, e plantas. O vírus de computador nada mais é do que um programa de computador, um conjunto de instruções, escrito em uma linguagem computacional como qualquer outro programa, e que viaja pelos mesmos tipos de mídia que qualquer outro programa, ou seja, discos fixos ou removíveis, e cabos de conexão entre computadores que formam redes de computadores, como a Internet (ver Parte 11).

Apenas o vírus é um programa que contém instruções que, em nossa linguagem, soariam mais ou menos como o seguinte: Toda a vez que você encontrar uma mídia computacional nova (discos, memória, cabos, etc.), faça uma cópia de você mesmo e coloque-a nessa mídia. É bàsicamente um programa do tipo DUPLIQUE-SE E INSTALE-SE POR ONDE PASSAR.

Incidentalmente, esses programas podem também conter instruções altamente daninhas, como APAGUE TUDO QUE ESTÁ NA MEMÓRIA OU DISCO RÍGIDO EM QUE VOCÊ ACABA DE SE INSTALAR, o que é suficiente para causar o "inferno de vida" de que falamos anteriormente. Ou ainda, pode causar os alto-falantes do computador emitir sons robóticos que soam sarcásticos como NÃO SE ASSUSTE, MAS INFECTEI O SEU COMPUTADOR, E O SEU DISCO RÍGIDO FOI TOTALMENTE APAGADO, seguido de uma risadinha eletrônica. Já pensaram que "inferno de vida"? Mas isso tudo é qualificado pela primeira palavra deste parágrafo: Incidentalmente!

A característica principal de um vírus de computador, a característica que o identifica como um vírus, é a instrução que diz DUPLIQUE-SE, escrita em uma linguagem que computadores obedecerão sem questionamento. Nós, humanos, podemos detestar isso o quanto quisermos, mas uma vez que essas instruções sejam escritas em uma linguagem reconhecida por computadores, estes a executarão da mesma maneira que executam instruções consideradas benígnas, como SOME DOIS NÚMEROS em um programa que emula uma calculadora, ou SUBLINHE ESTA FRASE em um programa de edição de textos, ou ainda AVANCE O PEÃO DO REI DUAS CASAS PARA A FRENTE em um programa que joga xadrez. Ainda mais, com os computadores hoje em dia conectados pràticamente a todos os outros computadores pela Internet (ver Parte 11), e com a facilidade de troca de discos, CD's, DVD's, "pen drives", etc., um programa que contém a instrução DUPLIQUE-SE E INSTALE-SE tem a capacidade de se espalhar como uma epidemia, e isso é o que realmente acontece, com centenas, milhares, milhões de cópias se espalhando pràticamente instantaneamente. O mundo cibernético de hoje é um paraíso para epidemias viróticas!

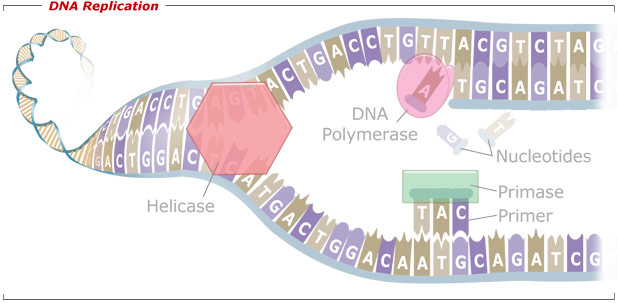

Os vírus biológicos são assustadoramente similares. Fundamentalmente um vírus biológico é um programa escrito em linguagem de DNA, que é exatamente como uma linguagem computacional, ao ponto de ser escrita em um código digital (quaternário — A-T-G-C). Como um vírus computacional, o vírus biológico simplesmente reza DUPLIQUE-SE E ESPALHE-SE! Não há aqui uma sugestão que os vírus, biológico ou computacional, querem se espalhar. Ocorre que para ambos, de todas as maneiras em que o seu código digital poderia se organizar em instruções, só aqueles que contém a instrução DUPLIQUE-SE E ESPALHE-SE acabam, de fato, gerando uma quantidade enorme de cópias de si mesmo, e se espalhando! Basta para isso que exista um maquinário pronto e capaz para executar as tais instruções, o que no caso do vírus computacional é a rede de micro e macro computadores interligados pela Internet, e no caso do vírus biológico é o maquinário celular existente nos seres vivos, incluindo nós, humanos, interligados como somos no ambiente em que vivemos, respirando o mesmo ar, e "trocando" células uns com os outros das mais variadas maneiras em que nos relacionamos (novamente, bem-vinda Lívia!!... :-).

É importante entender que os malefícios potenciais dos dois tipos de vírus são, como já mencionei, puramente incidentais, ainda que possam ter sido projetados por um programador mal-intencionado (computacional), ou por um laboratório de criação de armas biológicas (biológico). A verdade é que se os vírus não tivessem instruções do tipo DUPLIQUE-SE E ESPALHE-SE para garantir que êles continuem a existir, êles não existiriam. Os que não têm, ou nos quais tais instruções não funcionam a contento, morrem, vítimas de um processo de seleção natural. Diversidade e seleção natural no mundo biológico, e padronização (ou falta de) e homogeneidade no mundo cibernético (um vírus para os PC's perecendo em um MAC ou vice-versa...). E isso independentemente se o vírus computacional apaga ou não o seu disco rígido e faz gozação com você na tela e no alto-falante do seu computador, ou se o vírus biológico causa febre e problemas respiratórios no seu corpo.

A resposta ao leitor, portanto, é que não há um objetivo nobre, ou um porque para os vírus. Eles simplesmente existem porque são extremamente competentes em DUPLICAR-SE e ESPALHAR-SE, o que aliás é o objetivo puro e simples dos "vírus" que todos os seres vivos, incluindo nós, humanos, temos codificados digitalmente dentro de todas as nossas células (DNA), e que constroem nossos corpos para garantir DUPLICAÇÃO e ESPALHAMENTO, garantindo assim a permanência e a evolução da raça!

Agradeço a todos que viajaram comigo pelas 13 partes dessa viagem fantástica que foi UMA HISTÓRIA DA TECNOLOGIA DA INFORMAÇÃO. Continuaremos aqui no blog publicando sobre outros assuntos, ou seguimentos deste tema apaixonante, se comentários futuros de leitores assim o exigirem, e justificarem.

[Comente este Post]

Postado por Claudio Spiguel

1/12/2015 às 19h27

|

| |

Uma História da Tecnologia da Informação- Parte 12

Parte 12: Lembro aos leitores e leitoras que não leram Partes 1 - 11, que vocês podem acessá-las "clicando" no Mais Claudio Spiguel aí embaixo no rodapé do texto.

Além de publicar esta série no Digestivo Cultural, envio os textos para grupos eletrônicos dos quais participo assiduamente. Na Parte 11 da série escrevi que estamos nos aproximando do fim desta viagem fantástica, e recebi vários comentários lamentando que esse seja o caso... querem mais, e isso é confortante. Na verdade, como eu também escrevi na Parte 11, há muito mais a contar no tema, e estou pensando seriamente em usar esta série como base de um livro sobre o tema... graças ao retorno positivo de vocês, leitores e leitoras, portanto o meu muito obrigado. Alguns comentários recebidos incluíram perguntas específicas, portanto resolvi escrever esta Parte 12 abordando essas perguntas para não deixar nenhum "i" sem o pingo, e nenhum "t" sem o traço horizontal.

Um comentário continha a seguinte pergunta: "como é possível o meu computador estar ligado através da Internet a computadores de todo o mundo se só há um fio que vai do computador para o modem, e um fio só também do modem para a rede telefônica? " Bem... talvez a melhor maneira de visualizar o que realmente acontece é através da telefonia; o seu telefone, leitor, não tem uma linha física direta a todos os outros telefones do mundo, e, no entanto, você pode telefonar para todos eles. Quando você chama um certo número, o seu telefone é conectado a uma central (um computador chamado de "switch" ), que tem conexões com outras centrais com outros computadores "switches" , até que chega no computador "switch" ao qual está conectado o telefone que você está chamando, e só aí então uma conexão completa é estabelecida entre o seu telefone e o telefone chamado, através de todos os "switches" pelo caminho. É, de fato, o conceito de uma REDE.

TELEFONE ANTIGO, DE MANIVELINHA

Para tornar a visualização ainda mais clara, voltemos no tempo ao começo da telefonia, quando o telefone tinha apenas uma manivelinha, e em algum lugar da cidade havia sempre uma telefonista humana sentada na frente de um painel onde figuravam todos os (poucos) telefones da cidade (a telefonista e o painel formavam o "switch" da época). Quando você queria falar com alguém, você girava a manivelinha, e uma campainha tocava na sala da telefonista, e uma luzinha acendia junto a um furinho no painel rotulado com o seu telefone. A telefonista então estabelecia um contato com você fisicamente ligando um fone de ouvido no furinho com a luz acesa e você dizia a ela com quem você queria falar. Ela aí fisicamente conectava através de um cabo o furinho com o seu telefone com o furinho do telefone sendo chamado (da mesma maneira que era programado o ENIAC - veja a Parte 8) e o telefone chamado tocava e você estava então conectado ao seu interlocutor. Tudo isso era analógico.

TELEFONISTA E O PAINEL DE CONEXÃO

Uma vez digitizada a voz humana, e com os MODEMs (Parte 7) um computador "switch" substituiu o painel e a telefonista, e faz a conexão desejada através de um programa de software e as conexões de REDE existentes e disponíveis.

A Parte 11 tem ilustrações que mostram a evolução dos primeiros anos da ARPA-net, precursora da Internet, mostrando as conexões entre os computadores em rede; uma das características da Internet de hoje é o ALTO grau de redundância, ou seja, há uma miríade de caminhos para conectar o seu computador àquele que você está buscando, de modo a minimizar a dependência da conexão por qualquer computador específico. É por isso que é raro uma conexão falhar na Internet.

Um outro leitor comentou que a minha descrição e exemplos pareciam terminar no início dos anos 90, e portanto como é que eu dizia que havíamos chegado aos dias de hoje? O comentário falava até de jargões como Cliente-Servidor, Processadores Paralelos, e até o mais moderno "cloud computing" , ou Nuvem de Processamento. O meu esclarecimento ao leitor é que descrevi os três parâmetros FUNDAMENTAIS que definem o ambiente computacional de hoje: 1) a DISTRIBUIÇÃO da capacidade de processamento nutrida pela miniaturização dos componentes; 2) a DIGITIZAÇÃO das representações analógicas, principalmente da voz humana, fotos e filmes; e 3) a CONEXÃO entre os computadores por intermédio de REDES, principalmente a INTERNET. Após o aparecimento da Internet (1989) esses parâmetros continuaram evoluindo (um belo exemplo é o tipo de conexão entre os computadores, culminando com as conexões sem fio de hoje - Wi-Fi ), porém, nenhum OUTRO parâmetro fundamental apareceu para se juntar a esses.

O projeto de um sistema distribuído de processamento de dados envolve sempre duas questões fundamentais: 1) Em que computador reside que parte do sistema (no Cliente ou no Servidor, em que processador, em que ponto da Nuvem); e 2) Como é a rede de conexão entre esses computadores. Por exemplo, no sistema distribuído que eu divisei para datilografar, formatar, e imprimir a minha Dissertação de Doutorado (Parte 10) havia três processadores organizados em série: o IBM PC, o computador "mainframe" Amdahl, e o computador de controle da impressora XEROX 9700. A datilografia (elaboração, edição e armazenagem) do arquivo fonte ocorria no IBM PC; a formatação ocorria no Amdahl; e a impressão, na XEROX 9700. Por uma questão de marketing, os consultores na área de sistemas vão inventando aqueles jargões como se fossem coisas novas e diferentes, mas os princípios, os parâmetros fundamentais, são os mesmos.

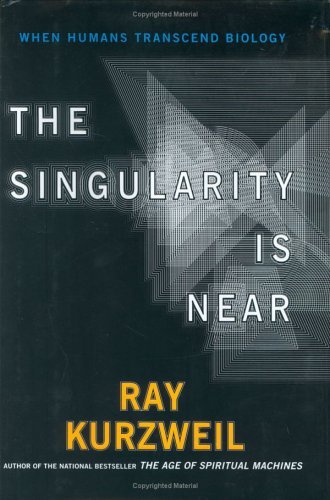

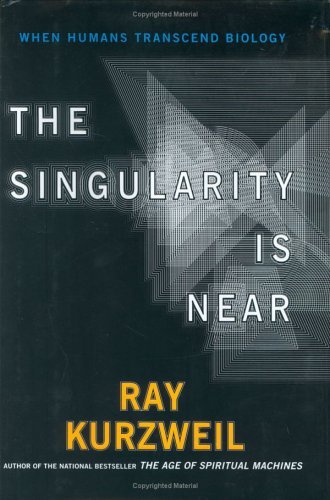

Vários leitores perguntaram se há tradução para o Português do livro que sugeri no fim da Parte 11, "The Singularity is Near..." escrito por Ray Kurzweill.

Pesquisei e a resposta é não; o livro é disponível no idioma original, o Inglês. O livro tem um subtítulo sugestivo: "Quando os humanos transcendem a Biologia...". A mensagem do livro é a seguinte: nós, humanos, somos a primeira espécie viva a criar uma tecnologia (os computadores) que podem nos ultrapassar.

CÉREBRO HÍBRIDO - A INTELIGÊNCIA NATURAL, E A ARTIFICIAL

Além disso, será possível um ser híbrido entre a nossa Biologia, e a nova Tecnologia que será um ser superior ao humano de hoje.

O SER HÍBRIDO, NA CONCEPÇÃO DO "STAR TREK"

O momento em que isso acontecer, Kurzweill chama de "Singularidade", e como diz seu título, ele julga que ele está próximo. Nesse contexto convém lembrar Darwin: "Não é o mais inteligente, ou o mais forte que sobrevive, mas sim, o mais adaptado."

Acho que a Parte 13 será o Epílogo desta série. Tenham todos a certeza de ter consigo os seus pertences de mão....

[Comente este Post]

Postado por Claudio Spiguel

11/10/2015 às 17h19

|

| |

Uma História da Tecnologia da Informação- Parte 11

Parte 11: Lembro aos leitores e leitoras que não leram Partes 1 - 10, que vocês podem acessá-las "clicando" no Mais Claudio Spiguel aí embaixo no rodapé do texto.

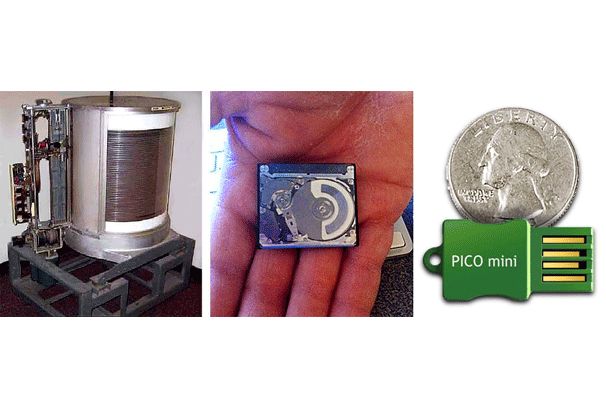

Conclui a Parte 10 dizendo que faltava apenas falar do conceito de REDE, mais especificamente a INTERNET, para chegarmos aos dias de hoje. Isso é um tanto simplista, mas é verdade. Falamos dos efeitos da miniaturização de componentes pavimentando a distribuição da capacidade de processamento dos computadores "mainframes" para os computadores pessoais. Falamos da invenção do transistor como gatilho desse processo, mas não foi só esse componente que sofreu miniaturização. Vale a pena mencionar a evolução dos discos rígidos para memória permanente.

Antes uma pequena digressão para que vocês entendam a medida de capacidade dos discos, inclusive termos que são comumente usados na descrição da sua capacidade de memória permanente: Um BIT é uma posição de memória, um dígito binário (0 ou 1). Um BYTE é uma sequência de 8 BITs, e em geral representa um caracter, uma letra ou um número decimal (isto é uma simplificação, mas serve os nossos objetivos). Um KILOBYTE (KB) é mil BYTEs. Um MEGABYTE (MB) é mil KBs, ou um milhão de BYTEs. Um GIGABYTE (GB) é mil MBs, ou um bilhão de BYTEs. Finalmente um TERABYTE (TB) é mil GB's, ou um trilhão de BYTEs.

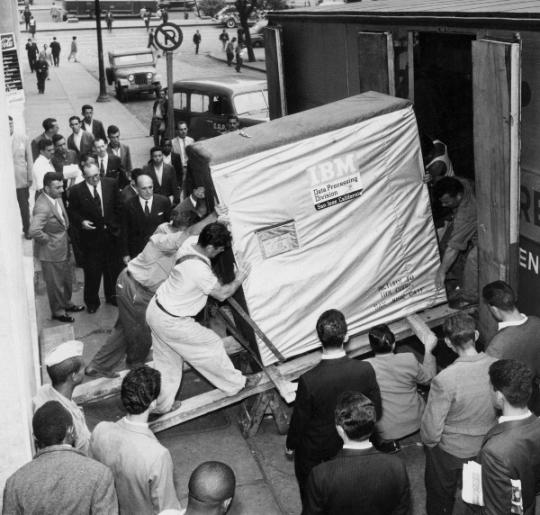

Pois bem, no final dos anos 50, a IBM oferecia uma unidade de disco rígido para ser acoplada a computadores "mainframes" que se constituia de uma pilha de 50 discos com 60 cm. de diâmetro cada um, uma monstruosidade que tinha a capacidade para armazenar apenas 5 MBs!! Quando eu ensinava na Universidade de Michigan nos anos 80 eu tinha uma unidade dessas para mostrar aos alunos, e eu a carregava para a classe em um carrinho com rodas, de tão pesada.

UNIDADE DE DISCOS RÍGIDOS IBM - 1950

O DISCO MAGNÉTICO DE 60 cm. DE DIÂMETRO

Hoje, o "notebook" que eu estou usando para escrever este texto tem UM disco rígido de 9 cm. de diâmetro e a unidade inteira, incluindo as cabeças de gravação e leitura tem 1.0 cm. de altura, e a sua capacidade é de 900 GBs, ou seja, CENTO E OITENTA MIL VEZES a do monstrengo descrito acima. Em cima da minha mesa de trabalho há uma caixinha (19cm x 11cm x 4cm) que contém UM disco com capacidade de 2 TBs, ou seja, QUATROCENTOS MIL VEZES a do monstrengo...

EVOLUÇÃO DOS DISCOS MAGNÉTICOS COM O "MOSTRENGO" AO FUNDO

e tem mais, o monstrengo custava QUARENTA MIL DÓLARES em dólares dos anos 50, ou seja TREZENTOS E VINTE MIL DÓLARES em dólares de hoje, e a caixinha com o disco de 2 TBs custa hoje CEM DÓLARES. Não é impressionante?

MINIATURIZAÇÃO DOS DISCOS MAGNÉTICOS COM O "MOSTRENGO" À ESQUERDA

Falamos também da digitização da voz humana, e mais tarde de textos, fotografias e filmes, elementos fundamentais da comunicação entre humanos tradicionalmente representados analogicamente, e que uma vez digitizados puderam ser manipulados, armazenados, e transmitidos por computadores.

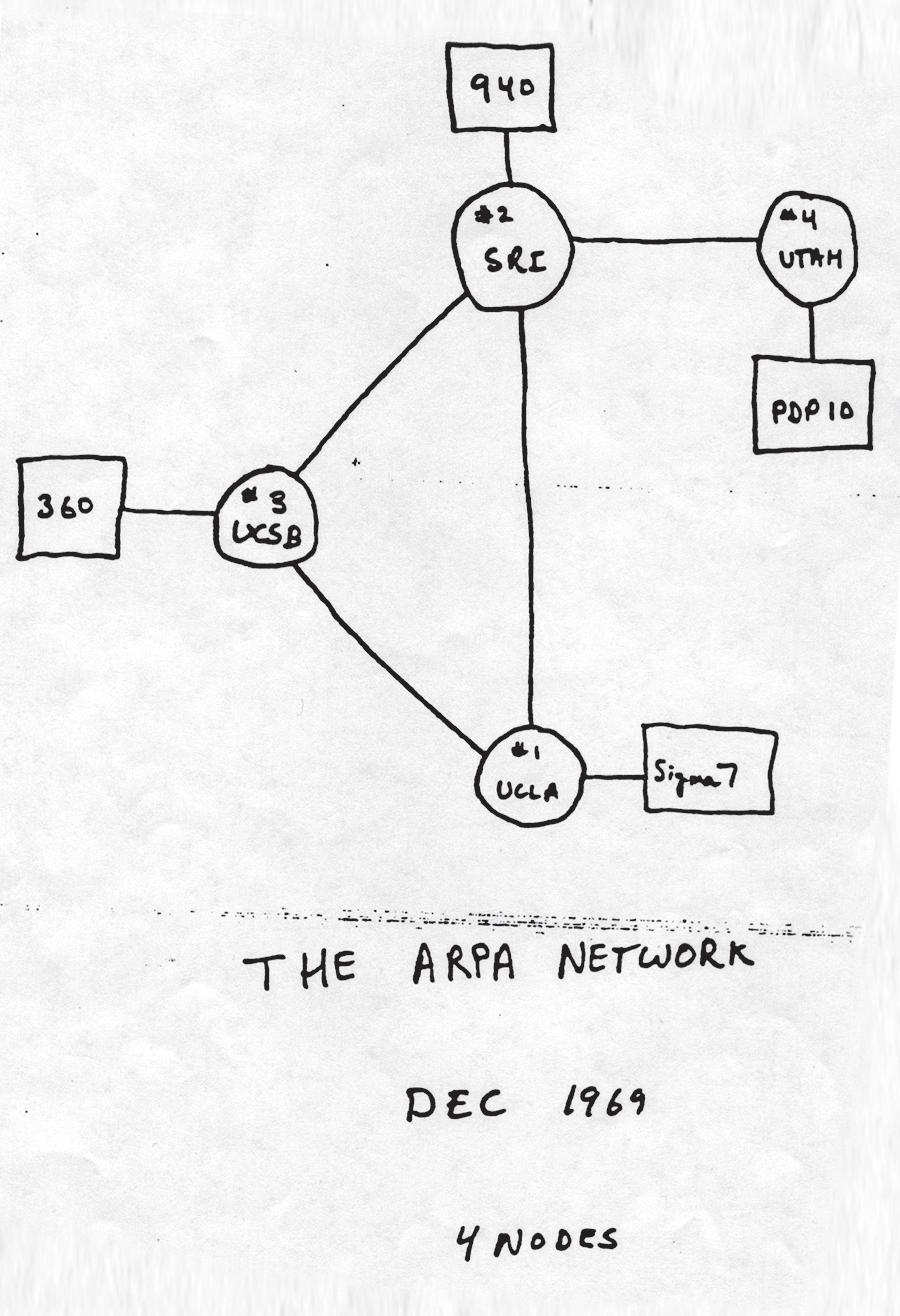

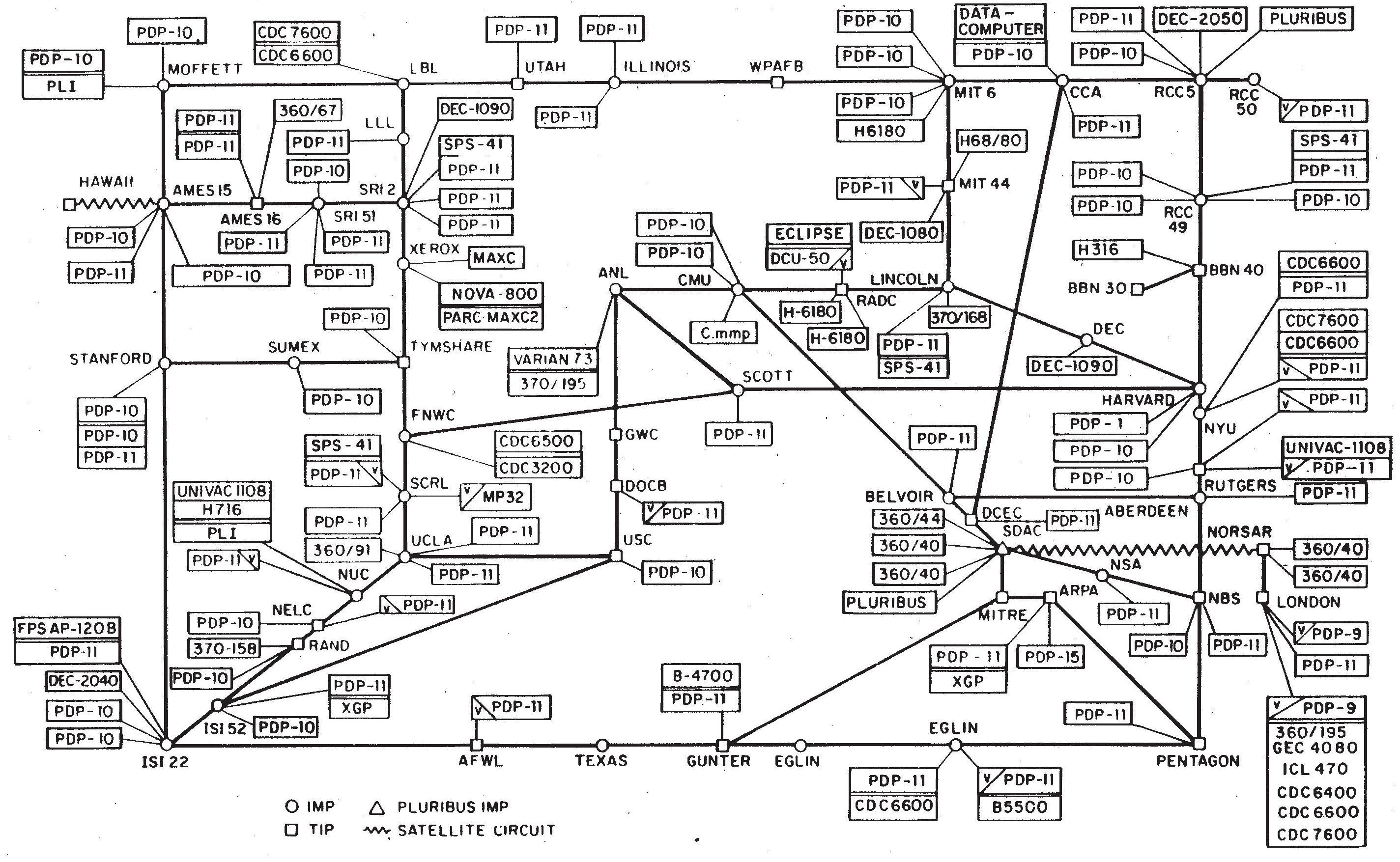

A terceira componente básica da evolução é a comunicação entre os computadores. Vocês devem se lembrar que mesmo com a distribuição da capacidade de processamento para os computadores pessoais, todos os computadores eram praticamente estanques, com pequenas exceções como as transferências de arquivos mencionadas nas Partes 7 e 10 usando um protocolo (padronização da informação transferida) chamado FTP - "File Transfer Protocol" , o único até então disponível e bastante inflexível e insensível ao conteúdo do arquivo. E foi mais uma vez no contexto militar que essa área foi suprida, com base em pesquisas realizadas em uma agência do Departamento de Defesa (DoD) Americano chamada ARPA - "Advanced Research Projects Agency" . O objetivo dessas pesquisas chamava-se "ARPA-net", ou rede ARPA, e visava conectar os computadores em campus universitários onde ocorriam projetos de pesquisa financiados pelo DoD. O primeiro desenho que se conhece da rede que viria a se tornar a INTERNET, unindo na costa oeste Americana os computadores da UCLA (Universidade da California em Los Angeles), UCSB (Universidade da California em Santa Bárbara), SRI ("Stanford Research Institute"), e Universidade de UTAH em Salt Lake City, Utah data de 1969, e foi feito à mão durante uma conversa entre os pesquisadores. E foi em Outubro daquele ano que a primeira transmissão bem sucedida ocorreu.

O PRIMEIRO DESENHO DA ARPANET, PRECURSORA DA INTERNET, EM 1969

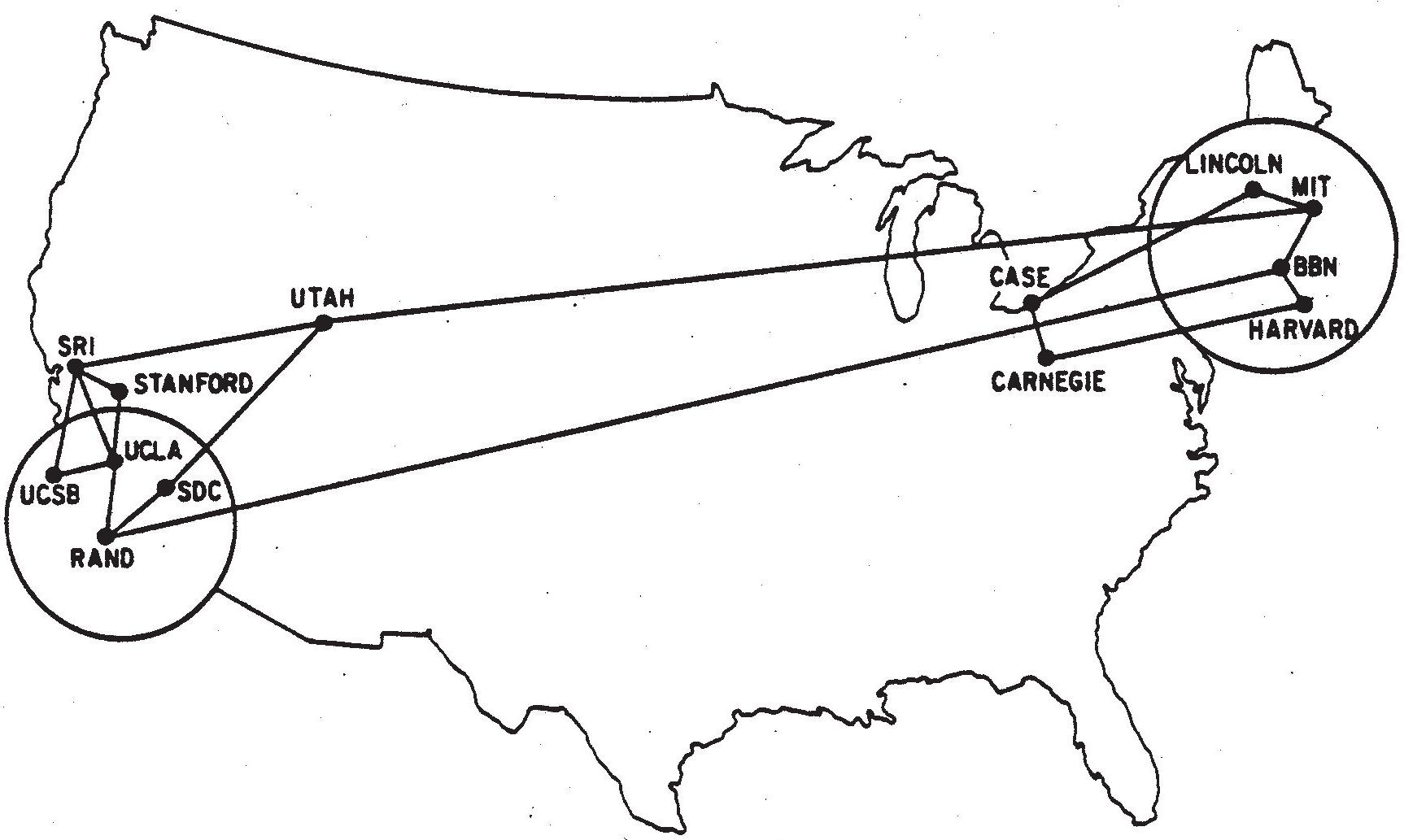

Já em 1970, um polo com vários nós foi adicionado à ARPA-net na costa leste Americana, incluindo a Universidade de Harvard, em Cambridge, Massachusetts.

A ARPANET, PRECURSORA DA INTERNET, EM 1970

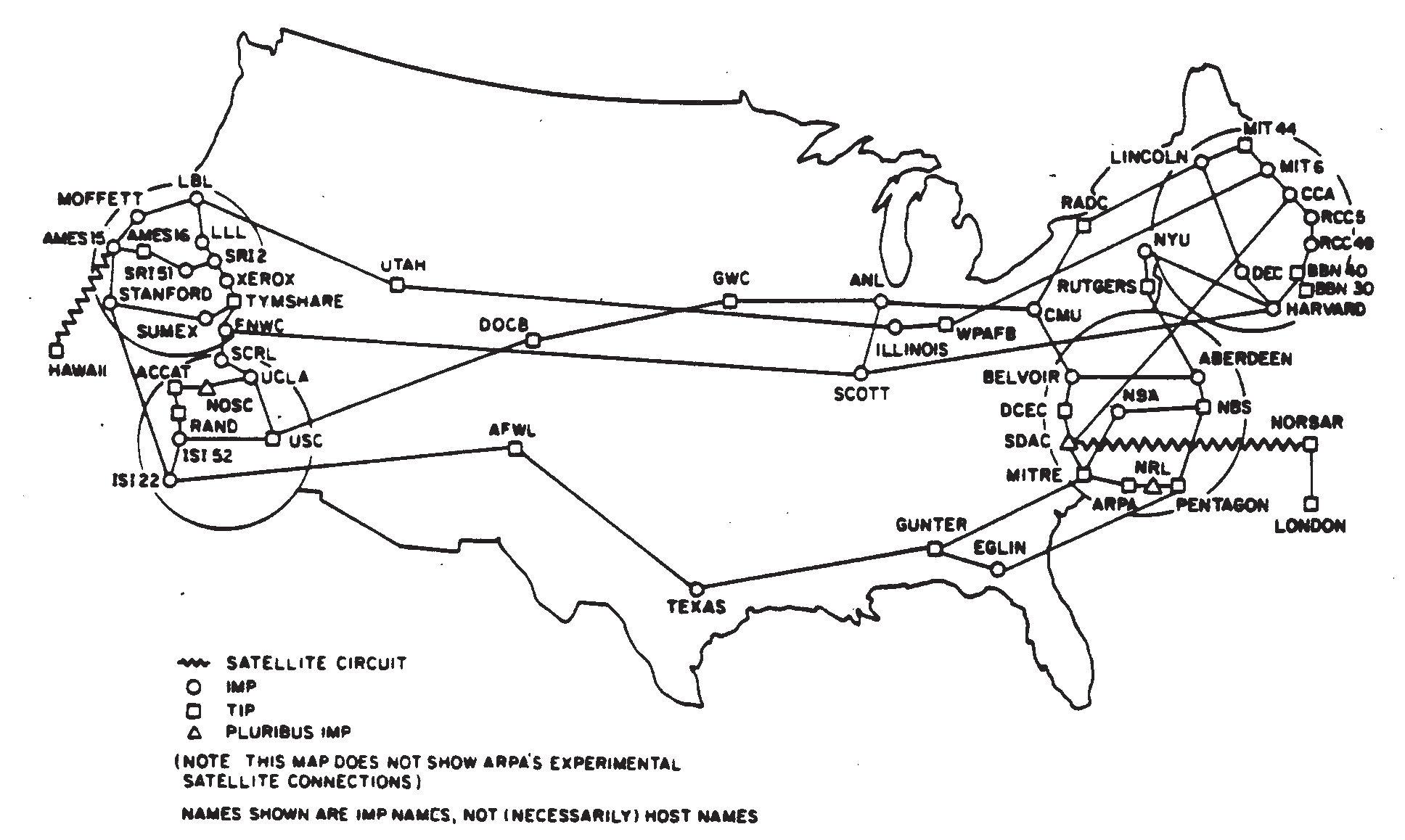

Durante os anos 70 várias outras Universidades uniram-se à ARPA-net e a pesquisa continou no intúito de enriquecer cada vez mais o protocolo de transmissão. Ficou claro, então que não só os projetos militares lucrariam através dessas conexões entre os computadores "mainframes" das Universidades, e a "NSF - National Science Foundation" começou a pressionar a ARPA para liberar a rede para uso Universitário, o que veio a ocorrer no início dos anos 80, sob o nome de NSF-net. Estava lançada a espinha dorsal da INTERNET.

A ARPANET, PRECURSORA DA INTERNET, EM 1977

Os anos que se seguiram viram a criação de um protocolo chamado "TCP/IP - Transmission Control Protocol/Internet Protocol" , cuja versão 4 é até hoje usada nas conexões da INTERNET. A riqueza desse protocolo, atingida com recursos públicos, criou a demanda comercial e industrial do uso da NSF-net o que ocorreu em 1989, marcando o nascimento oficial da INTERNET.

ESQUEMA TÉCNICO DA ARPANET, PRECURSORA DA INTERNET, EM 1980

Em 1993, como "CIO - Chief Information Officer" da firma Zeneca Pharmaceuticals, eu coordenei a conexão da rede interna da firma, a primeira da indústria farmacêutica, à INTERNET, agilizando sobremaneira os processos globais da empresa.

As três forças de MINIATURIZAÇÃO (distribuição da capacidade de processamento), DIGITIZAÇÃO (voz humana, textos, fotos e filmes), e CONEXÃO EM REDE (INTERNET) moldaram o ambiente que se vê hoje, onde com a capacidade de processamento dos nossos computadores pessoais, e no conforto das nossas casas ou trabalho, solicitamos um serviço, ou uma página de informações que reside em um outro computador em algum outro canto do mundo que tem um endereço único na Internet. Imediatamente uma conexão usando TCP/IP se forma através da INTERNET entre o nosso computador e o tal outro computador onde reside o que estamos buscando, e em segundos, o serviço ou página solicitada aparece na tela do nosso computador. Comparem isso com o uso do computador descrito nas Partes 1 e 2 desta série. Não é para menos que nos últimos 75 anos avançamos mais o nosso conhecimento do que em toda a história prévia da raça humana. Para uma visão do futuro dessa evolução, recomendo a leitura do livro "The Singularity is Near" (A Singularidade está Próxima) de Ray Kurzweill.

A viagem está no fim, mas ainda não terminou... ainda há mails algumas estações interessantes para o nosso trem parar... portanto ainda haverá algumas Partes... Não percam!

[Comente este Post]

Postado por Claudio Spiguel

23/9/2015 às 14h34

|

| |

Uma História da Tecnologia da Informação- Parte 10

Parte 10: Lembro aos leitores e leitoras que não leram Partes 1 - 9, que vocês podem acessá-las "clicando" no Mais Claudio Spiguel aí embaixo no rodapé do texto.

E lá estava eu, então, às voltas com como evitar a chateação e o custo de ter de usar um(a) datilógrafo(a) profissional para colocar minha dissertação de Doutorado no formato apropriado e aceitável para a Escola RACKHAM de Estudos de Pós-Graduação da Universidade de Michigan.

Escrevi na Parte 9 que o formato prescrito para dissertações de Doutorado é rígido. De fato, margens, fontes, sequência de páginas, numeração de páginas, índices, subtítulos, fórmulas, etc. são todos precisamente definidos (há manuais que contém essas definições), e qualquer desvio dessas normas pode fazer com que uma dissertação não seja aceita para defesa, e obtenção do título acadêmico. O conteúdo da dissertação é avaliado pelos professores da banca examinadora, mas o formato era verificado da maneira mais tradicional possível: entrava-se em uma sala na RACKHAM onde em duas mesas lado-a-lado estavam duas bibliotecárias especialmente treinadas nos tais manuais de formato. As duas se vestiam em estilo extremamente formal e conservador, óculos de leitura acomodados na ponta do nariz, e dedeira de borracha no dedo indicador da mão direita para virar as páginas dos dois, assim chamados, bonecos idênticos da dissertação (todas as páginas antes de serem encadernadas) que eram levados pelo autor à reunião. Em frente às mesas UMA cadeira, de onde o autor contemplava o virar ritmado das páginas pelas dedeiras de borracha; desvios das normas eram reportados em voz alta e anotados pelo autor para correção (possivelmente nova datilografia de grande parte da dissertação - ver Parte 9) e nova verificação em data posterior.

O motivo de haver DUAS bibliotecárias era que algo que escapasse a uma delas, muito provavelmente não escaparia à outra, garantindo assim o formato perfeito. E havia uma grande pressão, pois a cada candidato era facultado agendar apenas DUAS dessas reuniões, e se falhas fossem identificadas em ambas, o professor orientador era informado, e apenas mais uma reunião poderia ser marcada onde o candidato E o orientador deviam comparecer para verificação do formato. Falha nessa terceira reunião causava a NÃO-aceitação da dissertação e perda do título. Isso colocava os datilógrafos, também treinados no formato rígido, no caminho crítico de obtenção do título de Doutor pelo candidato, e obviamente havia uma comunicação velada entre a comunidade de datilógrafos da cidade, e as bibliotecárias da RACKHAM.

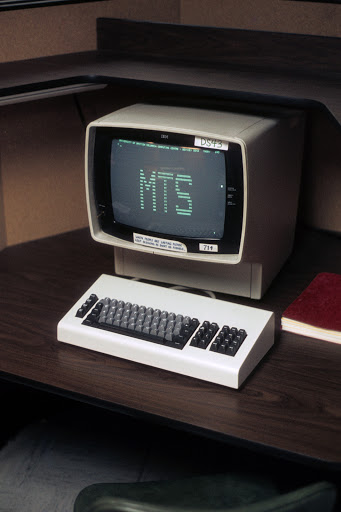

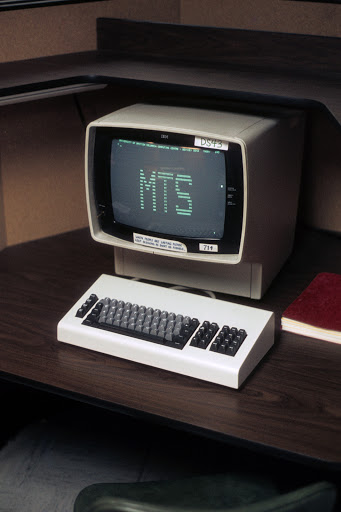

Conforme comentei anteriormente, a distribuição da capacidade de processamento, fruto da miniaturização dos componentes de processamento de dados por computadores, tendia a popularizar o uso do computador, e um dos primeiros usos a serem popularizados foi a edição de textos. Em particular, já dentro do MTS (ver Parte 5), um programa chamado TEXTEDIT foi desenvolvido exatamente para impor em um texto a formatação rígida de uma dissertação de Doutorado (rígida, porém totalmente mecânica, paginação automática, etc.). Os datilógrafos de início boicotaram o uso do programa, pois ele retirava uma das especialidades do serviço deles, paga a preço de ouro. Alguns, no entanto, aprenderam o uso do programa, e o utilizavam para gerar os tais bonecos para verificação, sabendo que isso não eliminava a datilografia do original final, pois as impressoras ligadas ao computador apenas imprimiam em formulários contínuos (ver Parte 9), e a qualidade do papel disponível nesses formulários não era aceita como original final. Apenas a primeira (mais horas pagas...) datilografia ocorria no teclado de um terminal burro IBM3270 (ver Parte 6) ao invés de em uma máquina-de-escrever. Até isso criava ainda mais uma exclusividade para os datilógrafos, pois lembrem-se que mesmo em "time-sharing" , o tempo de uso do computador "mainframe" era caríssimo (ver Partes 4 e 5), e catar milho com dois dedos no teclado dos terminais tornava o custo proibitivo.

Enquanto eu observava essa dança dos datilógrafos, eu estudei o uso das duas máquinas novas às quais eu tinha acesso como consultor do Centro de Computação da Universidade: o computador pessoal IBM PC e a impressora XEROX 9700 (ver Parte 9). Divisei então o seguinte processo: tendo já naquela época uma certa destreza em datilografia (hoje absolutamente necessária!), datilografei a minha dissertação diretamente no computador pessoal IBM PC (estanque, sem comunicação com o "mainframe" Amdahl, portanto sem custo), incluindo no arquivo os comandos para formatação do texto pelo programa TEXTEDIT, e no texto a ser impresso os comandos para a impressora XEROX 9700 (controle de fontes, inserção de letras gregas para fórmulas matemáticas, etc.). Com o arquivo pronto e conferido por mim mesmo, liguei o computador pessoal IBM PC como terminal remoto do computador "mainframe" Amdahl, exatamente como havia feito com a gambiarra descrita na Parte 7, e transferi o arquivo para o computador "mainframe" Amdahl para ser formatado pelo programa TEXTEDIT, e depois impresso na impressora XEROX 9700 em papel normal, de qualidade para impressão do original final. O resultado é que todas as alterações sugeridas pela banca examinadora eram feitas no arquivo original dentro do IBM PC (sem custo), e aí, com ele conectado remotamente ao Amdahl, eu pressionava UMA tecla no teclado do IBM PC, e da XEROX 9700 saia um original completo da dissertação, propriamente repaginado e formatado, pronto para encadernação. Notem que isso é exatamente o que acontece hoje quando usamos o programa WORD (ao invés do programa TEXTEDIT) para formatar um texto, e imprimi-lo nas impressoras a laser ou jato de tinta que temos em nossas casas acopladas aos nossos computadores pessoais!

Assim, munido de dois bonecos da dissertação gerados como descrito, lá fui eu encontrar as bibliotecárias da RACKHAM; as duas chegaram à última página sem qualquer desvio das normas de formato, mas a máfia dos datilógrafos estava alerta: uma delas disse: "Sabemos que o Sr. não usou um datilógrafo profissional, portanto não podemos aceitar a dissertação desde que o Sr. usou tecnologia que não está disponível a outros candidatos ao título de Doutor". Na semana seguinte, meu orientador e eu comparecemos a uma audiência com a Diretoria da RACKHAM, e conseguimos convencê-los de que uma Universidade devia encorajar, e não punir, o uso de tecnologia moderna (para aquela época...).

E foi assim que foi aceita na Universidade de Michigan, fundada em 1817, a PRIMEIRA dissertação de Doutorado que não passou pelas mãos de um datilógrafo profissional.

Vocês devem estar notando que estamos nos aproximando das estações finais desta nossa viagem fantástica. Na Parte 11 falaremos da conexão entre computadores, os primórdios do conceito de REDES, como a INTERNET, a qual nasceu e se estabeleceu como um serviço global. Vocês estão gostando da viagem...?

[Comente este Post]

Postado por Claudio Spiguel

16/8/2015 às 22h13

|

| |

Uma História da Tecnologia da Informação- Parte 9

Parte 9: Lembro aos leitores e leitoras que não leram Partes 1 - 8, que vocês podem acessá-las "clicando" no Mais Claudio Spiguel aí embaixo no rodapé do texto.

E um par de anos se passaram estudando, e ensinando História da Computação na Universidade de Michigan (ver Parte 8). No fim dos anos 70 a marcha da miniaturização (ver Parte 5) dos processadores, da memória interna (RAM - "Random Access Memory"), memória permanente (discos e fitas magnéticas), e praticamente todos os componentes daquela gambiarra que eu havia usado para o acesso remoto ao computador da Universidade (ver Parte 7) estava em franco progresso. Com o tamanho e o preço diminuindo, e a capacidade aumentando, todos vertiginosamente, a distribuição da capacidade de processamento (Parte 3) na direção de computadores pessoais se tornou uma realidade inevitável.

Uma firma chamada Apple já havia lançado uma série de "personal computers" - computadores pessoais (Apple I, II, III e LISA). O povo em geral, no entanto, ainda não havia se ligado no que estava por vir, e havia uma certa dúvida generalizada sobre a utilidade do que era ainda visto como apenas uma calculadora cara. A Apple oferecia apenas "software" (programas ou coleções de instruções que operam o computador) proprietário, e com isso poucos programas eram disponíveis para usos mais corriqueiros, como, por exemplo, edição de textos. O "marketing" da Apple era insuficiente para qualquer penetração significativa, e como o conceito de rede (conexão entre computadores) ainda era latente e os computadores pessoais da época, como os computadores "mainframes", eram praticamente estanques, o conceito como um todo parecia ter a aura de uma curiosidade de ficção científica, ao invés da ferramenta indispensável que é nos dias de hoje.

APPLE I

APPLE II

APPLE III

APPLE LISA

Mas aí, em 1981, o peso-pesado da indústria de computadores, a IBM, lançou o seu PC ("Personal Computer"), com o "software" de operação DOS ("Disk Operating System"), e o fez com esse sistema aberto (não proprietário), de modo que firmas de produção de "software", que não a própria IBM, foram incentivadas a criar e desenvolver uma miríade de programas para as mais variadas necessidades do dia-a-dia inicialmente profissional, e depois pessoal de indivíduos. Isso, aliado ao poder formidável de "marketing" da IBM, lançou de uma vez por todas o computador pessoal, e estabeleceu uma dominância de mercado para a IBM e máquinas compatíveis com o PC que se mantém até hoje.

IBM PC

Em 1980 a Apple havia evoluido o LISA para uma série de computadores pessoais denominados MACintosh, incorporando uma interface gráfica para os usuários e o aparecimento do "mouse"; na verdade, essa interface foi desenvolvida pela XEROX PARC - Palo Alto Research Center na California, mas os executivos da XEROX julgaram que esse era um produto sem futuro... IMAGINEM SÓ!! Incorporando o conceito de uma interface gráfica para usuários o DOS evoluiu para o que é hoje o WINDOWS da Microsoft. Perguntem ao Sr. Bill Gates se esse produto não tinha futuro...

APPLE MACINTOSH

Mas aí em 1981 o Centro de Computação da Universidade de Michigan adquiriu um IBM PC só com o intuito de ter um, sem muitos planos, apenas para pesquisa. Ao mesmo tempo, a XEROX desenvolveu a 9700, a primeira impressora para imprimir por laser em uma página normal de papel, ao invés das impressoras por impacto em formulário contínuo (aqueles com os furinhos nas margens esquerda e direita usados por catracas para avançar o papel). Essa nova impressora era uma outra revolução por si só, e para todo o controle da nova tecnologia de impressão era ela mesmo um outro computador que requeria uma sala inteira com ar condicionado para operar. Comparem com as impressoras de hoje... a Universidade de Michigan, como uma das instituições mais avançadas na Ciência de Computação da época, foi escolhida para testar a nova impressora, e uma foi instalada no Centro de Computação com acesso apenas para o pessoal interno ao Centro.

IMPRESSORA XEROX 9700

Eu, na época, estava começando a escrever a minha dissertação de Doutorado. Até então, a única maneira de publicar uma dissertação, um dos requerimentos para a obtenção do título de Doutor, era seguir o mesmo processo de publicação de um livro (a dissertação É um livro... a minha tem quase 300 páginas!), ou seja, pagar um datilógrafo profissional para datilografar o seu texto, projetar a paginação, inserir apropriadamente figuras, gráficos, fotos, tabelas, etc., fazer um índice de títulos e subtítulos, um índice remissivo de palavras-chave, uma bibliografia de citações e referências, notas de rodapé, e assim por diante. Dada a natureza evolutiva do texto de uma dissertação, com vários ciclos de leitura e comentários de todos os cinco professores da banca examinadora, esse processo era extremamente ineficiente e CARO (os datilógrafos profissionais eram pagos por hora de trabalho!).

O formato para aceitação de uma dissertação é bastante rígido, e portanto uma adição, correção, ou eliminação de um parágrafo, digamos, na página 20, praticamente forçava uma nova datilografia de TODAS as páginas a partir da 20, para acertar a paginação, inserção de figuras, índices, citações, etc. Os datilógrafos ganhavam a vida com essa história. A 2ª experiência minha relevante a como esse processo evoluiu aos dias de hoje foi como eu produzi a primeira dissertação na Universidade de Michigan sem o uso de um datilógrafo profissional, e direto da impressora para o encadernador. Os detalhes comporão a Parte 10. Não percam o trem, e continuem viajando comigo nessa viagem fantástica!

[Comente este Post]

Postado por Claudio Spiguel

2/8/2015 às 19h19

|

| |

Uma História da Tecnologia da Informação- Parte 8

Parte 8: Lembro aos leitores e leitoras que não leram Partes 1 - 7, que vocês podem acessá-las "clicando" no Mais Claudio Spiguel aí embaixo no rodapé do texto.

Prometi a vocês, leitores e leitoras, na Parte 7, a descrição de uma segunda experiência minha como consultor do Centro de Computação da Universidade de Michigan, enquanto fazia lá meus estudos de pós-graduação, relevante a esta nossa história da evolução das tecnologias de computação e comunicações que já tem oito partes... Essa experiência, no entanto, ocorreu alguns anos mais tarde, na conclusão dos meus estudos na Universidade de Michigan. Portanto, com o intuito de manter estas partes em tamanho compatível com "posts" em um "blog", creio que chegaremos nela nas Partes 9 e 10... Há muito que ver nesta nossa viagem fantástica!

Até chegar lá, onde descreverei aquela segunda experiência propriamente dita, aproveitarei para reforçar um pouco o ponto até onde chegamos, bem como cumprir outra promessa que fiz a vocês (ver Parte 3): uma viagem de volta no tempo também relevante, que ocorreu nos anos que se seguiram ao milagre e ao privilégio de ter sido a primeira pessoa a acessar remotamente o computador "mainframe" Amdahl da Universidade de Michigan. Essa primeira experiência inusitada, e bem-sucedida, levou o Centro de Computação a profissionalizá-la, e incentivar o acesso remoto ao computador para diminuir a demanda aos terminais dos centros-satélite, que já estava se tornando difícil de suprir (lembrem-se, 50.000 usuários! Ver Parte 7).

A figura acima mostra o Acesso Remoto ao Computador Mainframe (Parte 7)

Por exemplo, o programinha de sincronização dos modems que eu escrevi (o tal que ficava na fita cassete dentro do gravadorzinho de música) foi copiado e era distribuído gratuitamente a quem quisesse acessar o computador remotamente, ou em fitas cassete mesmo, ou em "Floppy Disks". "Floppy Disks" eram disquinhos flexíveis magnéticos que começavam a aparecer como dispositivos de memória permanente para serem usados pelos processadores que continuavam sua marcha de diminuição de tamanho e aumento de capacidade, fruto do esforço de MINIATURIZAÇÃO já mencionado anteriormente (ver Parte 5).

A figura acima mostra um FLOPPY DISK

Esse esforço levaria ao surgimento do computador pessoal, e à distribuição da capacidade de processamento, também já mencionada anteriormente (ver Parte 3). O computador pessoal será parte integrante daquela segunda experiência a ser narrada nas Partes 9 e 10, portanto vamos primeiro viajar de volta no tempo.

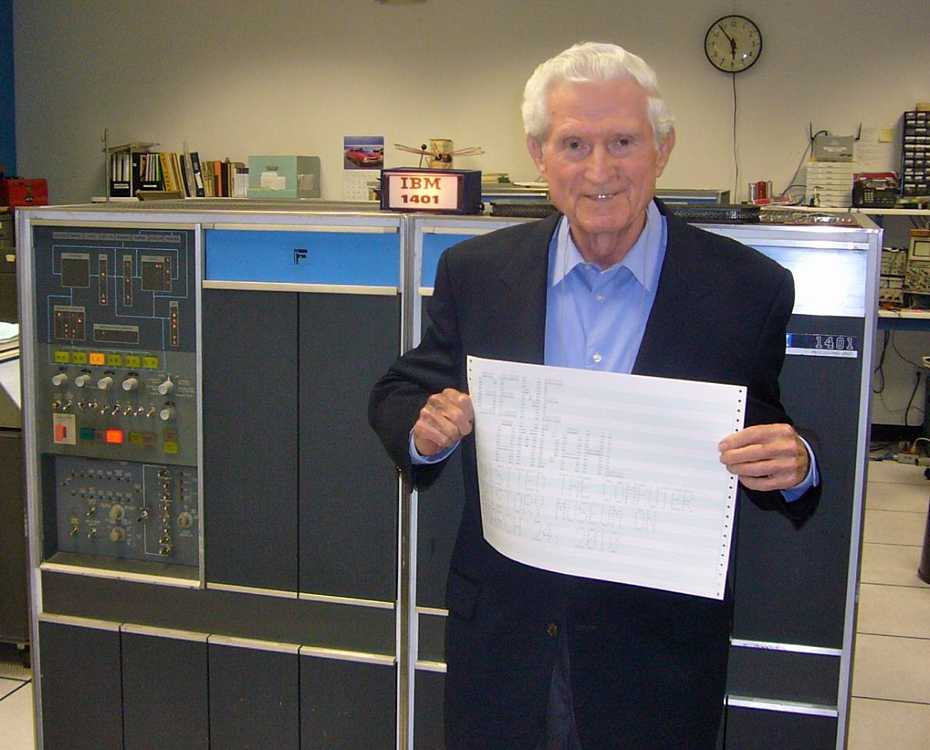

Um dos meus professores em Michigan foi Arthur Burks. Professor Burks já estava nos seus 60 anos, e ensinava o curso de História da Computação. Nada mais justo, desde que ele era parte dela!

A figura acima mostra o Prof. Burks nos anos 80, quando ensinávamos juntos

Há controvérsia sobre qual foi o PRIMEIRO computador, mas sem dúvida um dos candidatos fortes é a máquina conhecida por ENIAC — "Electrical Numerical Integrator And Computer" — Computador e Integrador Numérico Elétrico, construído na Universidade da Pennsylvania, em Philadelphia, entre 1942 e 1946, sob os auspícios das forças militares americanas para calcular trajetórias balísticas para a campanha dos aliados na 2ª Guerra Mundial (já falamos da influência dos militares e das guerras na tecnologia — ver Parte 1). Em 1947, como resultado desse trabalho de pesquisa, foi patenteado o ENIAC para fins comerciais.

A figura acima mostra o Prof. Burks nos anos 40 ditando um programa para uma programadora do ENIAC

A título de curiosidade, a representação digital (0s e 1s) interna no ENIAC era conseguida através de válvulas (o transistor ainda não tinha sido inventado); a memória do ENIAC consistia em quase VINTE MIL válvulas, e dado o tempo médio estimado de vida de uma válvula, a confiabilidade de operação do ENIAC se resumia a apenas algumas horas, após as quais era praticamente certo que alguma válvula da memória queimasse.

A figura acima mostra uma válvula energizada

A figura acima mostra um painel de montagem das válvulas no ENIAC

Não havia linguagem de programação (como o FORTRAN, mencionado na Parte 3), e os comandos de manipulação dos números eram comunicados ao ENIAC por pedaços de "hardware", literalmente cabos que definiam a trajetória dos números através dos componentes do computador. Pensem no seu computador pessoal de hoje... o quanto avançamos em meros 60 anos... Mas voltemos ao Prof. Burks, que foi membro do time de pesquisa que desenvolveu os fundamentos matemáticos e construiu o ENIAC! Tive o privilégio de ser seu assistente durante os meus estudos, e com ele ensinar o curso de História da Computação. Não há como descrever em palavras o privilégio de trabalhar com uma celebridade como o Prof. Burks; aprendi MUITO com êle.

Nos anos 60 a Universidade da Pennsylvania, que havia por todos esses anos mantido o ENIAC em condições de funcionamento, resolveu premiar os membros ainda vivos daquele time de pesquisa, e dividiu o ENIAC em partes auto suficientes e operacionais e deu para cada membro a oportunidade de adquiri-las; o Prof. Burks adquiriu quatro delas. Assim, a Universidade de Michigan recebeu as quatro partes do ENIAC, cuja operação foi incorporada pelo Prof. Burks ao currículo do nosso curso de História da Computação.

ENIAC em Michigan, mostrando os cabos que o programavam

Eu nunca vou esquecer a expressão de admiração na face dos alunos ao entrar na sala onde estava instalado o ENIAC, deparar-se com todas aquelas válvulas acesas, uma peça tão importante na história da computação. Eu entrava na sala para ensiná-los com muitos daqueles cabos de programação no bolso, e conforme percorria os fundamentos de matemática discreta em que se baseia a computação eletrônica, tirava os cabos do bolso e ia programando o ENIAC para executar como exemplo a operação que acabara de expor teoricamente. Nada como estar no lugar certo, na hora certa...

Prof. Burks e o ENIAC em Michigan, aos 90 anos

Arthur Burks faleceu em 2008 com 92 anos; com ele se foi uma parte da história da computação. Estamos agora prontos para relatar aquela segunda experiência mencionada no início deste "post", e seguir viagem. Prometo que ela será o âmago das Partes 9 e 10. Seguimos viajando juntos nesta viagem fantástica!

[Comente este Post]

Postado por Claudio Spiguel

25/7/2015 às 17h29

|

| |

Uma História da Tecnologia da Informação- Parte 7

Parte 7: Lembro aos leitores e leitoras que não leram Partes 1 - 6, que vocês podem acessá-las "clicando" no Mais Claudio Spiguel aí embaixo no rodapé do texto.

Não tinha muita ideia que chegaria a uma Parte 7, ou além, quando comecei esta série. Mas vamos em frente na nossa viagem, esperando que a série continue capturando sua imaginação e interesse através dessa história fantástica da evolução das tecnologias de computação e comunicações. E com exemplos que julgo significativos da minha carreira profissional, que praticamente encapsulou essa evolução. Talvez valha a pena repetir uma frase escrita anteriormente para recolocar o conteúdo em perspectiva para novos leitores: Jovens hoje nem conseguem imaginar a vida sem um computador pessoal e a Internet...

Bem, essa vida inimaginável foi, na verdade, razoavelmente recente. Era o final dos anos 70, e na Universidade de Michigan a revolução do uso do computador através do conceito de "time-sharing" através do MTS-Michigan Terminal System estava em franco progresso. O Centro de Computação da Universidade abriu vários Centros-satélite no campus onde alunos e professores podiam acessar o computador "mainframe" Amdahl simultaneamente através de Terminais VM3270 (ver Partes 5 e 6). Mas, como aluno de pós-graduação em Ciência de Computação e Comunicações, eu tive a oportunidade de trabalhar como consultor ao Centro de Computação, aplicando conceitos da área de pesquisa, e efetivamente planejando e acompanhando suas implementações práticas no serviço de computação da Universidade. Isso me deu uma janela privilegiada para ver o impacto da tecnologia na sociedade (a Universidade de Michigan tinha na época 40.000 alunos e um corpo docente de +/- 10.000 professores, portanto a comunidade alvo dos serviços de computação da Universidade era uma amostra significativa de 50.000 pessoas!).

Muita água passou por baixo dessa ponte, mas duas dessas experiências foram bastante significativas para a evolução que é o nosso assunto aqui; passo a narrá-las a vocês. Ambas têm a ver com as duas forças maiores já mencionadas várias vezes ao longo desta série: Miniaturização dos dispositivos de processamento, e Digitização da comunicação analógica, incluindo a da voz humana, alvo já conquistado pela telefonia (ver Parte 1). A comunicação entre os Centros-satélite e o computador localizado no Centro de Computação era feita através de cabos dedicados, troncos de cobre, e portanto transmissão analógica. Como tudo que acontece dentro do computador (e dos terminais) é digital (0s e 1s), há a necessidade de converter a informação de digital para analógica (terminal para o cabo), e depois outra vez de analógica para digital (cabo para o computador); isso é efetuado por dispositivos chamados MODEM ("MOdulator - DEModulator") que não carecem de maiores explicações aqui, mas que precisam existir tanto junto aos terminais, como junto ao computador. Na verdade, esses dispositivos existem até hoje nos aparelhos modernos, mas isso é para mais tarde na nossa viagem.

Um dia participei de uma conversa no Centro de Computação com o seguinte teor: por que não usamos os cabos de telefonia (cobre) para comunicação, e associamos um dos modems aqui a um número telefônico, aí alguém com um modem associado ao seu telefone poderia ter acesso remoto ao computador, sem ter de ir ao Centro-satélite, apenas ligando de seu telefone para aquele número. ACESSO REMOTO! IMAGINEM!! É claro que precisaríamos de um terminal junto ao telefone, e os terminais VM3270 eram caros, além de não terem qualquer outra utilidade.

Mas fiquei encafifado, e me ofereci para testar a alternativa: havia uma excitante! A Miniaturização dos dispositivos de processamento começava a gerar os primórdios dos computadores pessoais, e eu adquiri um "EXIDY Sorcerer", um dos primeiros disponíveis comercialmente. Pràticamente um teclado com um processador dentro, e conexões para um monitor, um modem, e um dispositivo genérico através de um pino RCA. Nenhuma memória permanente, como uma fita ou disco magnéticos, só memória (64 Kb) que só é ativa quando o computador está ligado, ou seja, ao desligar, perdia-se tudo que estava na memória. Mas o objetivo era um só... o acesso remoto.

Conectei uma velha TV branco e preto 14 polegadas como monitor, e um modem daqueles para telefones antigos, com os receptáculos para o encaixe da peça que levávamos à face com o microfone e o alto-falante.

Havia necessidade de um programa que sincronizasse a comunicação dos modems, e como nada podia ser guardado permanentemente no "Sorcerer", eu usava uma fita cassete em um gravadorzinho daqueles que usávamos para gravar e ouvir música em fita cassete, ligado ao computador através de um cabo que ligava a saída para o fone de ouvido do gravador ao pino RCA do computador.

Com essa gambiarra em cima da minha mesa em casa toda ligada, eu nunca vou esquecer do dia em que eu disquei o tal telefone do modem da Universidade, ao ouvir o modem responder, coloquei o fone no modem em cima da minha mesa, e apertei o botão "PLAY" no gravadorzinho, e após alguns segundos ansiosos, vi o cursor do MTS piscar na tela da TV. Em pouco mais de um ano, fui de ter de acordar às 2:30 da madrugada e me deslocar fisicamente ao prédio de um computador para usá-lo diretamente (ver Parte 6), para usar um a hora que eu quisesse da minha mesa de trabalho. Naquela época, era como um MILAGRE! A segunda experiência comporá a Parte 8. Não percam a continuação desta nossa viagem fantástica!

[Comente este Post]

Postado por Claudio Spiguel

17/7/2015 às 17h09

|

| |

Uma História da Tecnologia da Informação- Parte 6

Parte 6: Lembro aos leitores e leitoras que não leram Partes 1 - 5, que vocês podem acessá-las "clicando" no Mais Claudio Spiguel aí embaixo no rodapé do texto.

Antes de retomar a viagem a partir do começo da minha carreira nos Estados Unidos (12/1978), vale a pena enfatizar as consequências do Programa FLORA (o tal banco de dados de recursos naturais a nível nacional - ver Parte 5) de 1976 a 1978. Trouxemos o sistema operacional MTS - Michigan Terminal System, com o programa TAXIR, para o Brasil em 1977. Com ele veio o conceito de "time-sharing", primeiro sistema a incorporá-lo no Brasil. Ao chegarmos soubemos que a verba para "hardware" em qualquer solução havia sido negada pela então máquina de dizer NÃO do governo para importação de artigos de informática, a infame SEI - Secretaria Especial de Informática.

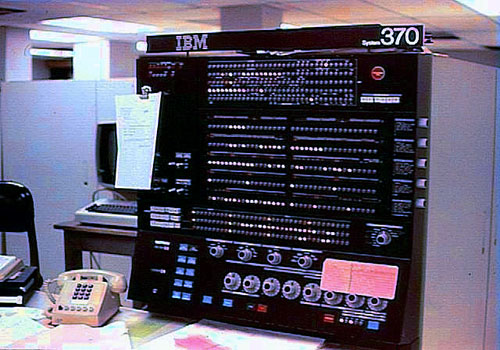

O time treinado em Ann Arbor para operação do sistema MTS incluiu um técnico da EMBRAPA, que estava interessada no uso do programa TAXIR para montar um banco de características genéticas de sementes, e a EMBRAPA possuía um computador IBM 370, sucessor mais poderoso dos IBM 360, no qual podíamos adaptar o MTS pela similaridade com os computadores Amdahl, conforme descrito na Parte 5.

E assim foi feito, mas conforme dito anteriormente, havia uma resistência do status quo, a turma do processamento em "batch", e o máximo que conseguimos foi uma hora de processamento na máquina durante a madrugada (2:30 às 3:30 da matina!), horário ideal para pessoas casadas há 5 anos, como eu... (risos)... mas o conhecimento da operação do sistema MTS residia com o nosso time, portanto tínhamos que, fisicamente, estar presentes para operar a máquina. Foram longas madrugadas...

Fizemos um contrato com o SERPRO para a digitação dos dados taxonômicos dos espécimes existentes nos herbários importantes dos Institutos de Botânica de São Paulo e do Rio de Janeiro, o INPA em Manaus, e o Museu Goeldi em Belém, e produção de fitas magnéticas com esses dados. Durante as madrugadas, nós operando o sistema operacional MTS no IBM 370 da EMBRAPA, o programa TAXIR lia essas fitas e codificava os dados, montando o banco de dados tão almejado. E como não dispúnhamos de verba (maldita SEI!!) para terminais e conexões, produzíamos um Catálogo Semanal com TODOS os espécimes catalogados, e o distribuíamos pelo correio não só para as organizações de origem, mas também para muitas outras Universidades e Institutos de Pesquisa que desejavam referenciar, ou solicitar empréstimo de espécimes para determinados estudos ou pesquisas.

Essa era uma solução MUITO aquém das visionárias imaginadas no início do projeto, porém um passo gigantesco, segundo os próprios pesquisadores das áreas de Botânica e Zoologia, que antes só teriam acesso àquelas coleções se visitassem pessoalmente as organizações de origem dos dados, e mesmo assim, sem uma visão completa de todos os espécimes existentes em todas as coleções. Era também possível, pela primeira vez, submeter questões ao time do projeto buscando subconjuntos de espécimes obedecendo um determinado conjunto de características expressado em álgebra booleana, o que era, na verdade, a vantagem principal de ter os dados codificados pelo programa TAXIR; por exemplo, podíamos submeter ao programa TAXIR perguntas como: Quais os espécimes catalogados de um determinado Gênero e uma determinada Família?, ou Quais os Gêneros representados no banco de dados por espécimes que apresentam folhas cordiformes (formato de coração)? As respostas às perguntas submetidas acompanhavam o próximo Catálogo Semanal. Os pesquisadores estavam simplesmente maravilhados com o serviço prestado.

Foi, no entanto, a consequência não almejada que acabou marcando época na história da computação no Brasil. Consciente do progresso representado pelo conceito de "time-sharing", contatamos os pesquisadores nas áreas de Física e Matemática da Universidade Federal do Rio de Janeiro (Praia Vermelha), que também possuía um computador IBM 370, e quando eles se deram conta do que era possível fazer com o sistema operacional MTS operando o computador da Universidade para as suas pesquisas, eles o levaram para lá, e essa foi a pedra fundamental do que hoje é o Instituto de Matemática Aplicada daquela Universidade, reconhecidamente uma das mais prolíficas e produtivas entidades de pesquisa em Matemática e Ciência de Computação da América Latina. O conceito de "time-sharing" havia chegado ao Brasil.

Em 26 de Dezembro de 1978, saí do Brasil (Rio 40 graus) com minha família (esposa e 4 filhos, idades 5, 4, 3 e 1 - descobrimos que não tínhamos mãos suficientes para eles e a bagagem de mão na escada rolante do aeroporto!) rumo a Ann Arbor, para iniciar nossos estudos de pós-graduação na Universidade de Michigan. Aterrissamos em Detroit, aeroporto mais próximo de Ann Arbor, no dia 27 (-5 graus, neve pelos joelhos...). O uso do computador Amdahl da Universidade também era ainda em "batch" - entrada em cartões perfurados, saída dias depois em listagens de papel contínuo, mas no Centro de Computação da Universidade já havia a pesquisa com o MTS que eu havia visto, e nos anos que se seguiram, houve uma explosão no campus de aparecimento de terminais IBM tipo 3270 (ver Parte 5) para o uso da máquina em "time-sharing".

Como eu já disse, uma verdadeira REVOLUÇÃO no uso do computador. E eu tive a sorte de estar lá, presente, para participar dessa revolução, dessa viagem fantástica que ora tenho o privilégio de compartilhar com vocês.

Os terminais, no entanto, só decentralizavam a entrada de dados e a saída de resposta, mas não a capacidade de processamento. Por isso, esses terminais eram conhecidos como "Dumb Terminals" - Terminais BURROS! Mas os caminhos da MINIATURIZAÇÃO lançados pela invenção do transistor nos anos 50, e os caminhos da COMUNICAÇÃO lançados pela digitização da voz humana nos anos 60, e os conceitos de rede no ambiente militar americano nos anos 70 provocaram uma inevitável DISTRIBUIÇÃO da capacidade de processamento para os terminais, que se tornaram os "personal computers", os computadores pessoais que apareceram no início dos anos 80, e evoluíram aos poderosos "desktops" e "laptops" de hoje.

A Parte 7 conta esse pedaço da história. Não percam a continuação da nossa viagem fantástica.

[Comente este Post]

Postado por Claudio Spiguel

2/7/2015 às 19h42

|

| |

Uma História da Tecnologia da Informação- Parte 5

Parte 5: Lembro aos leitores e leitoras que não leram Partes 1 - 4, que vocês podem acessá-las "clicando" no Mais Claudio Spiguel aí embaixo no rodapé do texto.

Naquela primeira visita à Universidade de Michigan em Ann Arbor, estado de Michigan, nos Estados Unidos em 1976, conheci detalhadamente o programa do Prof. George Estabrook, o qual havia conhecido na reunião da NSF - National Science Foundation (Parte 4). O programa se chamava TAXIR ("TAXonomic Information Retrieval" - Recuperação de Informação TAXonômica). Esse programa era exatamente o que precisávamos para o banco de dados de recursos naturais brasileiros. O Prof. Estabrook (amigo até hoje...) o havia desenvolvido juntamente com um programador profissional, por nome Robert Brill (outro amigo...), que também estava se transferindo para Ann Arbor para trabalhar no Centro de Computação da Universidade de Michigan, tudo por conta do inovador programa TAXIR que ambos haviam recentemente construído e publicado. TAXIR codificava a informação no processo de entrada dos dados (daí o requerimento de coleções estáticas, que não mudam com frequência uma vez estabelecidas) possibilitando um processo de saída, recuperação da informação, eficientíssimo! Era exatamente o que queríamos para computarizar a informação taxonômica descrevendo os recursos naturais brasileiros.

A decisão de obter o programa TAXIR foi imediata, mas êle acabou se tornando apenas uma porta de entrada, um veículo para algo MUITO maior, o passo seguinte na evolução da tecnologia de computação no Brasil, com a introdução do conceito de "time-sharing", ou seja, compartilhamento do tempo de uso do computador entre vários usuários, conforme necessidade evidenciada no artigo anterior desta série (ver Parte 4). Começava a engatinhar a POPULARIZAÇÃO, em paralelo com a PERSONALIZAÇÃO, do uso do computador.

O que eu vi em Ann Arbor ia muito além do motivo que havia me levado lá. Visitando o Centro de Computação da Universidade vi pessoas usando o computador através de dispositivos chamados terminais (figura abaixo), onde a comunicação entre o homem e a máquina se dava através de um teclado similar ao teclado de uma máquina de escrever (entrada) e uma tela de um tubo de raios catódicos, como uma tela de uma televisão, monocromática (caracteres de cor verde), que servia um objetivo duplo: 1) confirmava o que havia sido teclado pelo usuário repetindo a sequência de caracteres na tela antes dessa sequência ser enviada ao computador, com possibilidade de edição imediata; e 2) exibia a resposta do computador, quase que imediatamente! Além disso, vários usuários podiam fazer uso do computador através de vários desses terminais simultaneamente.

Comparem isso ao uso do computador até então no Brasil, descrito nos artigos anteriores desta série, um usuário por vez, entrada por cartões perfurados, resposta alguns DIAS mais tarde, em papel, e possibilidade de edição somente após essa resposta. Era uma revolução!

Michael T. Alexander, o pesquisador da IBM cedido à Universidade de Michigan havia usado sua experiência desenvolvendo o programa operacional VM ("Virtual Machine" - Máquina Virtual - ver Parte 4) para orientar o desenvolvimento do sistema operacional MTS - "Michigan Terminal System" - Sistema para Terminais de Michigan, que possibilitava o uso do computador através dos tais terminais descritos acima e por vários usuários simultaneamente, ao invés do esquema de uso tradicional ainda vigente, e único disponível no Brasil.

Não que tal uso fosse exclusividade brasileira, mas sim porque se prestava muito bem ao uso do computador como aquela calculadora gigante (ver Partes 2 e 3) em processamento de dados comerciais e financeiros, principalmente por bancos que eram os usuários principais naquela época. Esse tipo de processamento de dados se chamava de processamento em "batch" - conjunto, referindo-se ao conjunto de programas e dados representados em cartões perfurados que era carregado de uma vez para processamento do conjunto pelos computadores.

Os bancos, com seus processos em "batch", representavam o grosso da receita auferida pelos fabricantes de computadores como a IBM, e portanto a inovação do uso por terminais encontrava, como toda inovação, uma resistência pelo status-quo. Dentro da própria IBM, o engenheiro-chefe da arquitetura dos computadores 360 e os sucessores 370, Gene Amdahl, um visionário inovador, teve de sair da IBM para implementar suas idéias, fundando a "Amdahl Computers". Ele aparece abaixo, em Maio de 2010.

Sob sua orientação, a Amdahl fabricava computadores praticamente idênticos aos 370, mas com sistemas operacionais que viabilizavam o uso por terminais. O primeiro computador Amdahl (número de série 0001) foi instalado na Universidade de Michigan, e era operacionalizado através do sistema operacional MTS.

Imediatamente propus à Universidade de Michigan que juntamente com o TAXIR, trouxéssemos também ao Brasil o MTS, e foi assim, através desse projeto, que o conceito de "time-sharing" chegou pela primeira vez ao Brasil, em 1977. Os sistemas foram trazidos para o Brasil em fitas magnéticas transportadas por uma equipe sob minha coordenação, que levei a Ann Arbor para ser treinada na sua operação pelo Centro de Computação da Universidade. Duas curiosidades sobre esse transporte de sistemas merecem fazer parte desta nossa viagem:

1) Nos anos 70 a Guerra Fria entre Estados Unidos e Rússia estava no auge, e durante a reunião com o Presidente e a Diretoria da Universidade de Michigan na qual eu defendi o projeto que transferiu os sistemas para o Brasil, eu tive de assumir responsabilidade pessoal garantindo que o Brasil nunca deixaria os sistemas caírem nas mãos dos Russos. A questão e a exigência foram colocadas pelo Diretor Bernard Galler, cientista famosíssimo na área de Ciência de Computação, o qual anos mais tarde viria a fazer parte do meu comitê de Doutoramento. O nosso trem parará nessa estação alguns artigos à frente.

2) Quando nossa equipe chegou com as fitas no Aeroporto do Galeão, e depois no voo doméstico para Brasília, membros da Polícia Militar vieram nos receber e juntaram-se a nós para evitar que passássemos pelas rotas normais de segurança, desde que na época a SEI - Secretaria Especial de Informática proibia qualquer importação de tecnologia de informação, e as rotas normais forçariam que passássemos com as fitas pelos detectores de metais que apagariam seu conteúdo, inutilizando-as para os fins do projeto.

Mais sobre a SEI na Parte 6, onde exploraremos um pouco do impacto desse passo gigantesco na história da tecnologia de informação no Brasil, e onde começará a entrar na história a MINIATURIZAÇÃO, já em marcha nos Estados Unidos. Um prazer enorme seguir nessa viagem fantástica com vocês...

[Comente este Post]

Postado por Claudio Spiguel

22/6/2015 às 17h18

|

Mais Posts >>>

Julio Daio Borges

Editor

|

|